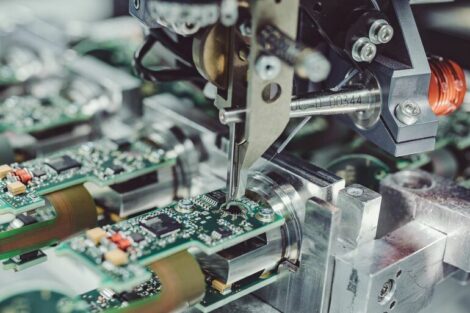

KEM Konstruktion: In den letzten Jahren haben sich Bildverarbeitungssysteme stark weiterentwickelt, sodass heute auch präzise 3D-Lösungen in Farbe möglich sind. Welche allgemeinen Trends kennzeichnen zurzeit den Markt der Bildverarbeitung?

Michael Beising (EVT): Aus unserer Sicht wächst der Markt für 3D-Lösungen weiter rasant, Aufgabenstellungen die vor Kurzem noch umständlich mit 2D-Kameras gelöst wurden, lassen sich heute mit den vorhandenen Sensoren einfach in 3D lösen. Gleichzeitig drängen immer mehr neue 3D-, Infrarot- sowie Multi- und Hyperspektral-Kameras auf den Markt, die neue Lösungen in den unterschiedlichen Anwendungsbereichen ermöglichen. Aufgabenstellungen werden einfach zu lösen, weil eben der „Kontrast“ und damit die Auswertung überhaupt erst möglich wird. Ein einfaches Beispiel dafür sind unter anderem Thermographiesysteme, die Wellenlängen aufnehmen, die sonst nicht detektiert werden können und somit zum Beispiel die Prüfung einer Siegelnaht auf einem bedruckten Produkt erst möglich machen. Neben den leistungsstarken sensorspezifischen Auswertungen, wird der Bereich der neuartigen Sensordatenfusion, wie etwa Terahertz- mit RBG-Daten, eine leistungsstarke Entwicklung erfahren. Damit ist der Trend zu neuen Sensoren, die Aufgabenstellungen einfacher lösbar machen, deutlich zu erkennen.

Uwe Furtner (Matrix Vision): Auch wir sehen das starke Interesse an 3D-Bildverarbeitung gepaart mit Farbe. Unsere 3D-Kamera mvBlueSirius hat die Top-Innovation-Auszeichnung 2015 bekommen, weil sie ab Werk kalibriert geliefert wird und Bewegungsvektoren einzelner Pixel im Raum liefern kann. Dies ist eine optimale Ausgangslage für Anwendungen in Sicherheitssystemen oder das Greifen unkontrolliert bewegter Objekte. Ein weiterer Trend sind Produkte, die es Einsteigern in die industrielle Bildverarbeitung so einfach wie möglich machen sollen: Die Industrie 4.0 hat einen enormen Bedarf an Inspektionen mit industrieller Bildverarbeitung. Jedoch sind Systemintegratoren ausgelastet und Fachkräfte Mangelware. Unser Zwillingskonzept aus der Smart Camera mvBlueGemini und der Smart Vision Software mvImpact Configuration Studio vereinfacht den Einstieg in die industrielle Bildverarbeitung und ermöglicht die Inspektionserstellung für Jedermann. Durch die automatische Szenenauswertung, die Wizard-gestütze Arbeitsweise sowie die intuitiv bedienbare Oberfläche können Inspektionsaufgaben ohne Bildverarbeitungs- und Programmierkenntnisse visuell, schnell und kosteneffizient in wenigen Minuten umgesetzt werden. Für dieses Konzept hat Matrix Vision auch eine Auszeichnung beim Innovationspreis 2017 des Landes Baden-Württemberg erhalten.

Johannes Giet (Isra Vision): Bedingt durch die Möglichkeiten, die mit neuen Hardware-/Embedded-Plattformen (COM+FPGA + GPU) sowie immer leistungsfähigeren preiswerten Kameras entstehen, entwickelt sich die Bildverarbeitung weg von komplexen Systemen hin zu smarten (Machine Learning), leicht bedienbaren, Industrie-4.0-konformen Sensoren. Neben der 3D-Messtechnik/Inspektion sowie der Multisensorik sehen wir verstärkt Trends in Richtung robotergestützte Anwendungen wie beispielsweise die Inspektion von komplexen Formteilen.

Christopher Scheubel (Framos): Embedded Vision macht die Bildverarbeitung zu einem integrativen Teil von Geräten und Maschinen. Dies führt zu einer Modularisierung und Verkleinerung aller Komponenten und eine stärkere Rechenleistung sorgt on-chip für mögliche Intelligenz. Der Nutzer kann zudem in vielen Fällen auf vorkonfigurierte und sofort einsetzbare Module zurückgreifen – der Entwicklungsaufwand und die Time-to-Market sinken deutlich. Moderne Kameramodule bringen vieles mit, was sich Nutzer bisher noch langwierig selbst evaluieren, einkaufen und zusammenbauen mussten. Mit Embedded Vision wird die Entwicklung einfacher und schneller, weil auf besser ausgestattete Komponenten mit mehr Funktionalität zurückgegriffen werden kann.

Albert Schmidt (Baumer): Die großen Trends sind 3D-Bildverarbeitung, Deep Learning, Embedded Vision sowie hyperspektrale Applikationen. Alle bieten großes Potenzial, neue Nutzergruppen und Anwendungsfelder zu erschließen oder die Lösung von Bildverarbeitungsanwendungen noch einfacher und effizienter zu gestalten.

Heiko Seitz (IDS): Die Bildverarbeitung eröffnet ständig neue Einsatzfelder für die Automatisierung von Produktionsprozessen, was zu einem immer stärkeren Einsatz von Kameratechnik in allen Bereichen der industriellen Fertigung führt. Die zusätzlichen optischen Informationen unterstützen die Fehlerfrüherkennung und steigern die erreichbare Qualität. Durch die Embedded Vision können viele Bildinformationen mittlerweile direkt on-camera ausgewertet und als prozessrelevante Informationen an die Steuerungsebene weitergeben werden. Mit der Bildverarbeitung von 3D-Informationen agieren Roboter in den Produktionsstätten außerdem zunehmend als selbständige und vielseitig einsetzbare Mitarbeiter. Eine sehr relevante Eigenschaft, die viele dieser neuen komplexen Bildverarbeitungssysteme mit sich bringen, ist deren Einfachheit in Anwendung und Wartung. Der Anwender muss immer weniger selbst mit den komplexen Algorithmen programmieren und kann auf einfachen Konfigurationsoberflächen prozess- und lösungsorientiert arbeiten. Die Bildverarbeitung wird daher immer stärker ohne Spezialwissen einsetzbar werden.

KEM Konstruktion: Unter dem Stichwort Deep Learning sind erste funktionstüchtige neuronale Netze entstanden. Insbesondere dadurch können inzwischen, neben reinen quantitativen Größen, zunehmend auch qualitative und dynamische Werte erfasst werden. Welche Möglichkeiten kann die Künstliche Intelligenz in der Bildverarbeitung bieten?

Beising (EVT): Die Systeme des Machine Learning (ML) und des Deep Learning (DL) sind der Einstieg in die Lösung von Aufgabenstellungen, die bisher nur schwer oder gar nicht zufriedenstellend gelöst werden konnten. Hierzu gehören alle Applikationen, die, wenn man es vereinfacht formuliert, der Mensch ohne Nachzudenken lösen kann: einen Kratzer auf einer Oberfläche erkennen, das Nummernschild an einem Auto detektieren oder ähnliches. Also intuitive Aufgaben, die eher zu den „automatisch im Gehirn“ ablaufenden Prozessen gehören. Solche Aufgaben sind mit DL realisierbar und hier sind die Netze unschlagbar – während sie für klassische Aufgabenstellungen, wie das dimensionale Messen, fast unbrauchbar sind. Wiederum ähnlich dem Menschen, der Dimensionen oft nur schwer schätzen kann und schon gar nicht hoch präzise. Die Anwendungsfälle für DL und ML sind im Umfang mindestens so groß wie die bisher mit Bildverarbeitung gelösten Aufgaben. Damit hat die künstliche Intelligenz sehr viel zu bieten.

Furtner (Matrix Vision): Deep Learning ist für die komplexe Datenverarbeitung in der industriellen Bildverarbeitung prädestiniert. In unserer Smart Camera mvBlueGemini verwenden wir im Bereich der Schrifterkennung Deep Learning, aber auch künstliche Intelligenz ohne neuronale Netze. Genauer gesagt haben wir unser Know-how in die Software einfließen lassen und konnten die Anwendung durch den integrierten Bildverarbeitungsexperten stark vereinfachen. Weitere Anwendungen sind im Bereich der Klassifikation von beispielsweise Obst und Gemüse beheimatet. Herkömmliche Lösungen benötigen hier zu lange Entwicklungszeiten und decken dann nur ein eingeschränktes Anwendungsfeld ab. Ein genereller Ansatz mit Deep Learning erlaubt dagegen eine schnellere Umsetzung ohne Programmierexpertise. Zu meiner Studienzeit 1990 gab es bereits einen Hype rund um neuronale Netze und damals konnten schon erstaunliche Ergebnisse erzielt werden. Es freut mich, dass nun die Rechnerarchitekturen ausreichen, um dies im industriellen Umfeld in Zusammenhang mit Bildern einsetzen zu können.

Giet (Isra Vision): In erster Linie können diese neuen Verfahren bestehende Bildverarbeitungstechnologien effektiv ergänzen und erweitern. Beispielsweise sind Texturen auf Material oder im Hintergrund für klassische Bildverarbeitungsalgorithmen störend. Künstliche Intelligenz unterstützt dabei, diese potentiellen Schwierigkeiten zu überwinden. Bei veränderlichen Merkmalen sowie bei komplexen Merkmalen hat die Künstliche Intelligenz Vorteile, da diese bei der Konfiguration nicht explizit beschrieben werden müssen. Im Lernprozess definiert die Künstliche Intelligenz das Merkmal mit, beziehungsweise lernt sie das Merkmal mit. So ist sie robuster gegen leichte Veränderungen der Merkmale und die Notwendigkeit der Beschreibung eines komplexen Merkmals entfällt. Klassische Bildverarbeitung wird dagegen über Formalismen wie Objektgeometrien konfiguriert. Die Entscheidung einer Künstlichen Intelligenz ist jedoch auch im Nachhinein nicht nachvollziehbar. Das liegt daran, dass sie kein für uns verständliches, oder sagen wir formales, Merkmal nennen kann, aufgrund dessen die Entscheidung gefällt wurde. Im Ergebnis wird durch den Einsatz neuronaler Netze aber eine kaum abzuschätzende Menge neuer Anwendungen realisierbar. Gleichzeitig wird die Einrichtung in diesen Anwendungen intuitiver und einfacher gestaltet. Das minimiert den Aufwand bei der Inbetriebnahme.

Scheubel (Framos): Das Potenzial von Deep Learning ist riesig und umfasst alle Industrien. Im Moment werden Deep-Learning-Ansätze hauptsächlich zum Klassifizieren verwendet. Das heißt, bei der Qualitätsüberprüfung in OK/NOK oder bei der Sortierung in zuvor festgelegte Klassen. In Zukunft werden insbesondere die Objekterkennung und die Deep-Learning-basierte Prozessoptimierung eine Rolle spielen. Die Kombination aus Deep Learning und Embedded Vision bietet spannende Aspekte. Embedded Vision als Kombination aus Bilderfassung und -Verarbeitung mit einem dedizierten Prozessor arbeitet mit FPGA‘s, einer CPU oder auch GPU. Wenn die Deep-Learning-Anwendung auf diesem Prozessor stattfindet, dann ist es Teil einer Embedded-Vision-Applikation und kann Maschinen zu intelligenten und selbstlernenden Partnern machen.

Schmidt (Baumer): Ein lang gehegter Traum ist es, einen Prüfling unter die Kamera zu halten und das intelligente optische System gibt aus, ob der Prüfling OK oder NOK ist. Natürlich ohne vorher trainiert zu sein. Alle Stufen zwischen diesem Ziel und dem heutigen Stand sind hochwillkommen. Primär ist Deep Learning jedoch – trotz aller Euphorie – ein weiteres Werkzeug im Tool-Kit industrieller Bildverarbeitung.

Seitz (IDS): Künstliche Neuronale Netze (KNN) interpretieren komplexe Bildinhalte mit unerreichter Genauigkeit und bieten Lösungen, die sich durch die menschliche Programmierung mit grundlegenden Algorithmen bisher selbst mit hohem Aufwand nicht realisieren ließen. Diese klassische Bildverarbeitung tritt für viele Anwendungsfälle immer mehr in den Hintergrund, da KNNs wichtige Bildmerkmale anhand vorsortierter (gelabelter) Bilddaten selbstständig lernen. Mit entsprechenden Datensätzen kann ein vorhandenes KNN für die Erkennung unterschiedlicher Merkmale trainiert und damit wiederverwendet werden. Neben der Qualitätssicherung oder der vorbeugenden Wartung in der industriellen Produktion sind beispielsweise auch Einsätze in der medizinischen Diagnose oder Lagerprüfungen in Einzelhandel und Logistik denkbar. Durch sogenannte KNN-Beschleuniger – Chips mit hoher Rechenleistung bei geringer Leistungsaufnahme – wird zudem der effiziente Einsatz im Embedded-Vision-Bereich möglich. Mit der Verbreitung und Vernetzung solcher cyberphysischer Bausteine werden Prozessdaten verfügbar, welche die Automatisierung und das Verarbeitungstempo von Prozessen der industriellen Fertigung nachhaltig vorantreiben.

KEM Konstruktion: Darüber hinaus gewinnen Themen wie Embedded Vision und die hyperspektrale Bildverarbeitung an Bedeutung. Welche Entwicklungen stehen dazu bei Ihnen an?

Beising (EVT): Unsere Softwareprodukte laufen auf allen Plattformen komplett parallel. Unsere Kunden haben somit die Wahl, ob sie ein Embedded-System mit einem ARM-Prozessor oder ein x86-basiertes PC-System mit Windows oder Linux verwenden wollen. Dass die Systeme je nach Aufgabenstellung skalierbar sind, macht es unseren Anwendern möglich, jeweils die optimale Hardware auszuwählen. Den Anfang hierfür bildeten die intelligenten Kameras, meist mit einem ARM-Prozessor unter Linux, wobei der Trend derzeit eher zu kleinen Embedded-Plattformen mit einem aktuellen ARM-Prozessor aus der letzten Mobilplattformgeneration geht. Diese Systeme sind um ein Vielfaches leistungsfähiger und gleichzeitig um ein Vielfaches preisgünstiger als die intelligenten Kameras. An sie können dann die gleichen bewährten Industriekameras angeschlossen werden, wie sie auch im x86-PC-Umfeld verwendet werden. Die geringe Leistungsaufnahme sowie die kleine Bauform in Scheckkartengröße ermöglichen es zudem, dass die Systeme überall untergebracht werden können. Für diese Embedded-Plattformen, genauso wie für die x86-PC-Systeme, können dann beispielsweise auch Hyperspektralkameras eingesetzt werden. Leider ist deren Einsatz heute, ob des hohen Preises, noch sehr beschränkt, obwohl sie für viele Anwendungsfälle die optimale Lösung wären. Hier wird sich hoffentlich, wie im Infrarotkamerabereich für Thermographielösungen, der Preis auf ein anwendbares Niveau reduzieren.

Furtner (Matrix Vision): Embedded Vision bieten wir schon seit vielen Jahren an – sei es als OEM-Kameramodule, im Treibersupport für Linux basierte Embedded Boards oder in Form unserer intelligenten Kameras. Und die hyperspektrale Bildverarbeitung kann Probleme lösen, die bislang kaum lösbar waren, wie etwa die Prüfung, ob und wie viele Arzneimittel wirklich in einer Tablette enthalten sind, oder eine Unterscheidung zwischen Nutzpflanzen und Unkraut, beziehungsweise zwischen Kartoffeln und Steinen. Allerdings werden viele Daten generiert, die ausgewertet werden müssen oder am Ende wieder verworfen werden. Damit ist der Nutzungsgrad der Sensorfläche nicht optimal und das macht die Technologie teuer. Generell bietet sie mit für bestimmte Anwendungsbereiche hergestellten Sensoren auch in Stückzahlprojekten viele Chancen.

Giet (Isra Vision): Embedded Vision ist seit Jahren ein fester Bestandteil in unseren Produkten. Wir haben viele Applikationen, bei denen Auflösung und Verarbeitungszeit, also die Bandbreite, ein entscheidender Erfolgsfaktor ist. Dabei verwenden wir Multiview-Hybrid-Technologien basierend auf COMs (Computer-on-modules) in Verbindung mit FPGAs/GPUs und adaptierbaren Beleuchtungen. Unter Berücksichtigung der mechanischen Abmessungen lassen sich unsere Industrie-4.0-Sensoren (Edge-Computing) daher nur mit Embedded-Technologien wirtschaftlich umsetzen. Multiview- und Multispektrale-Anwendungen sind ebenfalls seit Jahren fester Bestandteil in der Inspektion, beispielsweise in der Druckbildinspektion oder der Inspektion von beschichteten, mehrlagigen Oberflächen. Und hyperspektrale Anwendungen entwickeln sich zunehmend mit der leistungsfähigeren Kameratechnologie. Neben der klassischen Aufnahmetechnik bieten entsprechende Kameras eine einzigartige Möglichkeit, spektrale Zusatzinformationen in der Bildanalyse (Sensorfusion) zu berücksichtigen. Diese werden zum Beispiel in der Evaluierung bei der Inspektion von Bahnware auf Fremdpartikel und das Erscheinungsbild, bei Analysen von Schichtdicken auf diversen Materialien sowie bei der Lebensmittelsicherheit/-hygiene in sichtbaren und zunehmend nichtsichtbaren Spektralbereichen bereits eingesetzt.

Scheubel (Framos): Framos steht seinen Kunden von der ersten Idee eines Vision-Projektes über die Machbarkeit, die Evaluierung der passenden Komponenten bis zur Umsetzung als Berater und Partner zur Seite, inklusive Entwicklungsdienstleistungen und weiteren Services. Unsere Experten setzen alles daran, dem Kunden die Entwicklung zu vereinfachen und seine Time-to-Market zu verkürzen. Etwa mit Evaluation-Boards, (Semi-)Custom-Sensoren, 3D-Modulen, sofort einsetzbaren Kameralösungen oder auch unserem neu entwickelten SLVS-EC IP Core, der Sony’s SLVS-EC-Sensoren standardisiert mit Xilinx-FPGA’s verbindet. Unser Ziel ist es, dass Kunden von den Vorteilen der Bildverarbeitung profitieren und sich selbst auf ihre Kernkompetenzen fokussieren können, während ihre Maschinen das Sehen lernen.

Schmidt (Baumer): Die hyperspektrale Bildverarbeitung und die Embedded Vision befinden sich bei uns aktuell in unterschiedlichen Entwicklungsstadien – zu früh, um bereits Details zu kommunizieren.

Seitz (IDS): Der wachsende Einsatz bildbasierter Prüfverfahren erfordert immer spezialisiertere Bildverarbeitungssysteme, um optische Informationen möglichst effektiv nutzen zu können. IDS wird deshalb das Embedded-Vision-Konzept IDS NXT weiterentwickeln, mit dem sich Prüfergebnisse einfacher Auswertungen bereits kameraseitig erzeugen lassen. Die Vision-App-basierte Industriekamera-Plattform wächst konsequent um zusätzliche Familien mit weiteren Sensoren und Kommunikations-Schnittstellen. Zudem wird auch unser Bereich der Ensenso-3D-Kameratechnik um neue Modelle erweitert, welche die Berechnung der 3D-Objektdaten erstmals selbst – also ohne PC-Unterstützung – durchführen und die 3D-Punktewolken per GenICam direkt an eine Steuerungseinheit weitergeben. Das vereinfacht die Infrastruktur des Gesamtsystems, reduziert den Bilddaten-Traffic und beschleunigt die 3D-Datenerstellung durch Hardware-Unterstützung.

KEM Konstruktion: Auf der Automatica 2018 haben die OPC-UA-Arbeitsgruppen Bildverarbeitung und Robotik des VDMA die ersten Spezifikationen veröffentlicht. Welche Rolle spielt das M2M-Kommunikationsprotokoll OPC UA und sind die Hard- sowie die Softwareschnittstellen für die zukünftigen Anforderungen ausreichend standardisiert?

Beising (EVT): Für uns ist es erst mal wichtig, dass es Standardprotokolle gibt, die es ermöglichen, einfach zwischen verschiedenen Systemen unterschiedlicher Aufgabenstellungen und damit Herstellern, sowohl horizontal wie auch vertikal, zu kommunizieren. Hier ist mit der Standardisierung für die Bildverarbeitung und Robotik im OPC UA sicher ein Fortschritt erzielt worden. Für das heterogene Umfeld der SCADA-Systeme in der Fabrikautomatisierung und der industriellen IoT sind die Definitionen der OPC UA sicher eine nützliche Definition, die es einfacher macht, die Daten unter den Systemen auszutauschen.

Furtner (Matrix Vision): Wir sind sehr glücklich über die schnelle Erstellung der OPC UA Companion Specification für die Bildverarbeitung. Zusammen mit der Industrie 4.0 steigen die Anforderungen, Informationen auch vom Bildverarbeitungssystem zur Steuerung oder in die Cloud zu liefern. Schließlich sind Industriekameras die Augen einer Fertigungsmaschine. Ohne diese Augen wäre die Steuerung blind. Daher haben auch wir bei dieser Spezifikation mitgearbeitet und integrieren sie in unsere Smart Vision Systeme.

Giet (Isra Vision): OPC UA wird als allgemeine herstellerunabhängige Schnittstelle künftig eine bedeutende Rolle in der M2M-Kommunikation spielen. Die vorgestellten Spezifikationen sind ein wichtiger Schritt auf diesem Weg, und sie werden noch weiter entwickelt, ergänzt und verfeinert werden. Der Standardisierungsvorgang ist hier noch nicht abgeschlossen aber ein sehr wichtiger erster Teil des Weges wurde bewältigt.

Scheubel (Framos): OPC-UA ist ein wichtiger Schritt für Embedded Vision und auf dem Wege zur vernetzten Produktion, da die Komponenten schneller integriert werden können und das System echtzeitfähig wird. Für Kundenanfragen greifen wir auf die Spezifikationen des VDMA zurück. Aus unserer Sicht liegt sehr viel Potenzial in dem Kommunikationsprotokoll, dessen Nutzwert gerade erst erschlossen wird.

Schmidt (Baumer): Baumer ist aktiv an diesem Thema beteiligt, um den Standard zu spezifizieren und zu entwickeln. Es besteht breiter Konsens in der Branche, dass dies ein wichtiges Thema ist. Entsprechend ist auch die allseitige Bereitschaft der Zusammenarbeit. Bezüglich der Schnittstellen gibt es aktuell sicherlich noch viel zu tun. Aber die Branche hat ja auch beim GenICam-Standard bewiesen, dass eine zielorientierte Zusammenarbeit am Ende erfolgreich ist.

Seitz (IDS): Mit unserer neuen Vision-App-basierten Kamera-Plattform stellen wir ein vollständig integriertes Embedded-Vision-System zur Verfügung, das neben der industriellen Nutzung auch in vielen anderen Märkten eingesetzt werden kann. Passende Schnittstellen zur Weitergabe von erzeugten Ergebnissen und zur Kommunikation mit dem Host-System können wir flexibel adaptieren. Wir verfolgen die Entwicklung von OPC UA deshalb sehr genau. Mit den geplanten Erweiterungen um ein Publish/Subscribe-Modell und dem Time-Sensitive-Networks-Standard (TSN) kann es auch für die herstellerunabhängige Informationsbereitstellung zwischen BV-System und der Steuerungsebene in Produktionsanlagen zur einheitlichen Sprache werden. Mit einem Standard wie OPC UA werden die Branchen weiter zusammenwachsen, was Synergien und Produktverbesserungen mit sich bringen wird.

www.baumer.com, Messe Vision 2018: Halle 1, Stand 1F32

www.evt-web.com, Messe Vision 2018: Halle 1, Stand 1A63

www.framos.com, Messe Vision 2018: Halle 1, Stand 1C42

www.ids-imaging.de, Messe Vision 2018: Halle 1, Stand 1F72

www.isravision.com, Messe Vision 2018: Halle 1, Stand 1C30

www.matrix-vision.de, Messe Vision 2018: Halle 1, Stand 1E12

Direkt zu den Besucherinformationen der Messe Vision 2018:

„Für uns ist es wichtig, dass es Standardprotokolle gibt, die es ermöglichen, einfach zwischen verschiedenen Systemen unterschiedlicher Aufgabenstellungen und damit Herstellern, sowohl horizontal wie auch vertikal, zu kommunizieren.“

„Die hyperspektrale Bildverarbeitung kann Probleme lösen, die bislang kaum lösbar waren, wie etwa die Prüfung, ob und wie viele Arzneimittel wirklich in einer Tablette enthalten sind.“

„Die Entscheidung einer Künstlichen Intelligenz ist auch im Nachhinein nicht nachvollziehbar. Das liegt daran, dass sie kein für uns verständliches, formales, Merkmal nennen kann, aufgrund dessen die Entscheidung gefällt wurde.“

„Embedded Vision macht die Bildverarbeitung zu einem integrativen Teil von Geräten und Maschinen. Dies führt zu einer Modularisierung und Verkleinerung aller Komponenten und eine stärkere Rechenleistung sorgt on-chip für mögliche Intelligenz.“

„Ein lang gehegter Traum ist es, einen Prüfling unter die Kamera zu halten und das intelligente optische System gibt aus, ob der Prüfling OK oder NOK ist. Natürlich ohne vorher trainiert zu sein.“

„Der Anwender muss immer weniger selbst mit den komplexen Algorithmen programmieren und kann auf einfachen Konfigurationsoberflächen prozess- und lösungsorientiert arbeiten.“