Um das Verhalten von Vorgängen in Produkten zu überprüfen, weit bevor Prototypen existieren, hat sich die Simulation als bewährtes Werkzeug etabliert. Sie zerlegt den zu untersuchenden Gegenstand in kleine Teile, nimmt für jedes dieser Elemente eine homogene, kontinuierliche Struktur und ein bestimmtes Verhalten an und überprüft dann, wie sich das auf die Nachbarelemente auswirkt. Das Ganze basiert auf kontinuumsmechanischen und experimentell bestätigten Ansätzen. Die bekannteste Methode zur Lösung kontinuumsmechanischer Probleme ist die Finite-Elemente-Methode (FEM-Simulation), heute fester Bestandteil der Produktentwicklung.

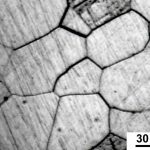

Immer höhere Anforderungen an die Produkte erfordern aber auch detailliertere Modelle, um etwa Werkstoffeigenschaften in Crashtests genauer simulieren zu können. Hier kommt die FEM-Simulation an ihre Grenzen. Vergrößert man die Struktur von Stahl unter dem Mikroskop bis auf die mesoskopische Kristallstruktur, zeigt sich diese nicht mehr homogen – wie von der FEM angenommen –, sondern das Metall offenbart große Strukturschwankungen und Unsicherheiten im Inneren. Die Korngrenzen sind unregelmäßig – genau dort ändern sich aber die Materialeigenschaften. Ein solches Verhalten setzt sich fort bis in die subatomare Mikroskala, dort gilt die Heisenbergsche Unschärferelation: Sie besagt, dass zu einem festen Zeitpunkt entweder der Ort oder die Geschwindigkeit eines Elektrons messbar ist – nicht aber beides.

Mit diesem unsteten Verhalten kommt die makroskopische FEM-Simulation nicht zurecht, weil sie lediglich ein Hilfsmittel zur Lösung vieler Differentialgleichungen ist – je größer der Rechner, desto feiner und schneller das Modell. Multiphysik-Simulation heißt hier nur, dass man etwa bei einem Gießvorgang gleichzeitig mehrere Strömungsberechnungen über die Navier-Stokes-Gleichung und thermische Fragen über die Fourier-Gleichung löst. „Und selbst das ist noch nicht ausgereift, weil in den Solvern nur die Abkühlung und das Fließverhalten gekoppelt werden, in der Regel die Schrumpfung aber noch nicht berücksichtigt wird“, erläutert Andreas Burblies, Sprecher der Allianz ‚Numerische Simulation‘, in der 18 Fraunhofer-Institute zusammenarbeiten. Dadurch gebe es aber einen Spalt, der den Wärmeübergang beeinflusst. „Dieser wird immer noch über semi-empirische Ansätze oder beim Reverse Engineering über Versuche ermittelt.“

Das natürliche Chaos

Vorgänge, die mathematisch durch eine stetige Funktion beschreibbar sind, bezeichnet man als kontinuumsmechanisch. Die Natur sieht aber in sehr kleinem Maßstab ganz anders aus, unstetige Dinge wie die Korngrenzen im Stahl sind nur ein Beispiel. „Hier helfen stetige Funktionen nicht, denn die Poren in einem Metall tauchen mal hier, mal da auf“, so Burblies weiter. „Die FEM kann nicht mit Sicherheit sagen, an welcher Stelle sie auftreten – sie kann nur angeben, zu welchem Anteil sie gleichmäßig über das Blech verteilt sind, beispielsweise zu fünf oder zehn Prozent.“ Die FEM erzeugt bei gleichen Parametern immer gleiche Ergebnisse, was hier aber gerade nicht dem Abbild der Realität entspricht. Diese ist hier stochastisch, sprich bei Wiederholung desselben Vorgangs treten die gleichen Vorgänge nur manchmal ein und sind für den Einzelfall nicht vorhersagbar.

Die Begriff Stochastik stammt aus dem altgriechischen und bedeutetet zu Recht in etwa ‚Kunst des Vermutens‘. Ein klassisches Beispiel ist das Zerreißen eines A4-Papierblattes: Man setzt an der oberen Seite zwei Schnitte und zieht das Blatt dann auseinander. Nach FEM-Ergebnissen müssten die Risse bei gleichem Versuchsaufbau in einer Vorrichtung jedes mal an der gleichen Stelle senkrecht nach unten verlaufen und ein Papierstreifen in der Mitte herausfallen. Die Realität zeigt aber immer ein Rissmuster, das einen der beiden Risse bevorzugt.

Im Crashtest beim Auto will man aber genau wissen, wo es wann und wie zu Rissen, Brüchen und Verformungen kommt. Die Fraunhofer-Institute für Werkstoffmechanik (IWM) und Fertigungtechnik und angewandte Materialforschung (IFAM) arbeiten daher mit Stochastik-Ansätzen, um Porositäten in Werkstoffen zu simulieren. Das Problem sind hier nicht deren Lösungen, sondern der Nachgang. Denn anschließend benötigt man Übergangsskalen, um die Effekte im Kleinen mit den Auswirkungen im Großen – zum Beispiel via FEM ermittelt – zu verbinden. „Wir müssen die mikroskopische, atomare Skala mit der mesoskopischen Gefügeskala – beide stark stochastisch veranlagt – mit der kontinuumsmechanischen Makroskala der sichtbaren Objekte zu einer Multiskalensimulation verbinden“, fasst Burblies zusammen. „Dieses Problem müssen wir momentan noch lösen.“ Dafür gibt es aber zur Zeit einige öffentliche und industriell geförderte Projekte.

Die Herausforderung besteht darin, ein Mindestmaß an übertragenen Informationen, einen angemessenen Berechnungsaufwand und die Qualität der Vorhersage für den jeweiligen Anwendungsfall auszubalancieren. Ebenso ist das Verständnis von elementaren Verformungs- und Bruchprozessen eine Voraussetzung und muss daher gründlich erforscht werden: Verformt sich ein Metall, verschieben sich innerhalb der einzelnen Kristalle die Atomlagen gegeneinander und erzeugen so einzelne Versetzungen. Wenn man voraussagen möchte, wie und wann Werkstoffe versagen, muss also bekannt sein, nach welchen Regeln diese Versetzungen in unterschiedlichen Werkstoffen entstehen, wie sie sich bewegen und miteinander wechselwirken. Professor Peter Gumbsch vom Fraunhofer IWM konnte zum Beispiel zeigen, dass Versetzungen in Extremfällen sogar schneller als der Schall durch einen Kristall laufen können. Um eine vollständige Multiskalensimulation zu ermöglichen, muss also auch immer wieder grundlegendes Materialverhalten erforscht werden.

Crashtest unter dem Mikroskop

Heute entscheiden Materialeigenschaften bei einem Crash darüber, ob sich das Blech des Fahrzeugs nach innen oder außen wölbt. Dabei können auch die Postionen von Poren eine Rolle spielen. Aktuelle Simulationen können aber beispielsweise nur mit einer Wahrscheinlichkeit von 80 % angeben, dass in einem bestimmten Bereich eine Pore liegt. „Daher berechnen wir dann einfach viele Möglichkeiten und würfeln quasi via Stochastik in jede eine Pore rein“, fährt Burblies fort. So erhalte man etwa 100 unterschiedliche Bauteile. Die Streuung der Ergebnisse zeigt, wie abhängig die Materialeigenschaften von der Position der Poren sind. Künftig soll die Simulation zeigen können, wie ein Bauteil oder Material aussehen muss, damit die Unsicherheiten der Stochastik keine Rolle mehr spielen. „Dann spricht man von ‚Robust Design‘ – wobei robust immer ‚sicher gegen stochastische Streuung’ bedeutet, und genau das wollen wir ja.“ Forscher am Fraunhofer-Institut für Werkstoffmechanik IWM in Freiburg und Halle können auf diese Weise Materialstrukturen und -funktionen gezielt gestalten. Sie decken Einflüsse von Kristalldefekten und Gefügestrukturen auf das Materialverhalten im Großen auf.

Die Multiskalensimulation bedeutet aber nicht das Ende der FEM, sie ist lediglich für sehr kleine Maßstäbe geeignet. Sobald ein Problem keine große Streuung mehr erwarten lässt – also in einem kontinuumsmechanischen Ansatz lösbar ist –, bleibt die FEM erste Wahl. Die Multiskalensimulation ist zudem auch kein völlig neues Feld, es gab bereits Ende der 90er Jahre einen Hype, ausgelöst in den USA. Dort proklamierte man, dass man bis 2020 die makroskopische Ebene mit der atomaren Ebene koppeln könne und so Produktentwicklungszyklen von zehn auf zwei Jahre eindampfen werde. Burblies verfolgte die Entwicklung seit den großen Ambitionen: „Wie so oft wurde der Hype aber von der Realität eingeholt, etwas Arbeit haben wir noch vor uns.“

Auch andere ‚Welten‘ gilt es zu verschmelzen

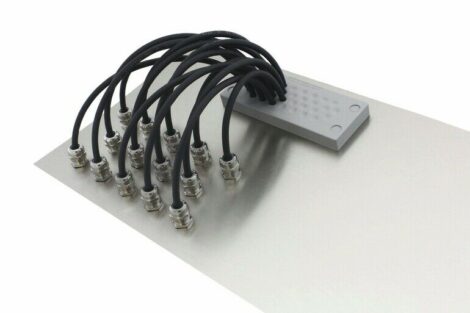

Ein weiteres Forschungsgebiet der Fraunhofer-Forscher verschmilzt die Simulation mit der virtuellen Realität, die Rede ist dann von der ‚simulierten Realität‘. Der fallende Apfel wird hier wirklich beschleunigt und nicht nur mit einer konstanten Geschwindigkeit bewegt“, betont Burblies. Heutige virtuelle Echtzeitsimulationen vernachlässigen häufig die physikalischen Eigenschaften des zu simulierenden Objektes. Allerdings muss beispielsweise die Elastizität einer Komponente innerhalb der Simulation berücksichtigt werden, wenn Kühl- oder Hydraulikschläuche innerhalb einer virtuellen Entwicklungsumgebung gehandhabt werden sollen. Exemplarisch hat das Fraunhofer-Institut für Produktionsanlagen und Konstruktionstechnik (IPK) neue Methoden zur virtuellen Handhabung flexibler Bauteile wie Hydraulikleitungen oder Schläuche entwickelt und prototypisch implementiert. Auf Basis der damit durchführbaren Ein- und Ausbauuntersuchungen lassen sich Bewegungspfade und Volumen aufzeichnen und für folgende Entwicklungsprozesse verwenden.

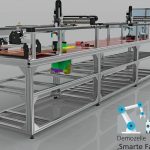

Mit einem größeren Konzept wollen Forscher des Fraunhofer IPK zudem die Vision der Industrie 4.0 realisieren. Ein digitaler Zwilling bildet den gesamten Produktionsprozess ab und ermöglicht jederzeit den direkten Eingriff in die Fertigung. Reale und virtuelle Produktion verschmelzen zu einem intelligenten Gesamtsystem, die reale Produktionsstätte wird vollständig auf digitaler Ebene nachgebildet. Der auf diese Weise entstehende virtuelle Zwilling visualisiert nicht nur die Produktionsanlage mit allen Maschinen, sondern er gibt auch die dynamischen Abläufe und das Verhalten der Systembestandteile während der Fertigung in Echtzeit wieder – im virtuellen Zwilling lässt sich der Fertigungsprozess also detailliert beobachten. Da zahlreiche Sensoren den Betriebsstatus der einzelnen realen Arbeitsstationen laufend an das System weitergeben, eröffnen sich für die Steuerung der Produktion neue Möglichkeiten: Die Produktionsplaner können den Herstellungsprozess im virtuellen Abbild analysieren und dann gegebenenfalls einzelne Schritte optimieren oder neu organisieren.

Intelligent auf Änderungen reagieren

Das Konzept des digitalen Zwillings geht jedoch weit über ein bloßes Abbilden der realen Produktionsanlage hinaus. Tatsächlich kann das System bidirektional funktionieren. Greift man auf der virtuellen Ebene ein um Änderungen vorzunehmen, lassen die sich sofort simulieren und testen. Auf diese Weise könnte der Produktionsleiter beispielsweise weitere Maschinen für die Bearbeitung eines Werkstücks aktivieren oder einen zusätzlichen Arbeitsschritt einbauen; etwa, wenn eine Sonderanfertigung verlangt wird. Die Fertigung muss dazu nicht gestoppt und neu konfiguriert werden, vielmehr reagiert das System intelligent auf jede Änderung und organisiert sich neu.

Durch die Verschmelzung von realer und digitaler Produktion entsteht ein Gesamtsystem, das sich im laufenden Betrieb selbst überwacht, steuert und korrigiert. Maschinen und Software kommunizieren – soweit erforderlich – unabhängig vom Menschen miteinander und halten so die Produktion in Gang. Sollte beispielsweise eine Störung vorkommen, wie etwa der Ausfall eines Aggregats, kann das System selbstständig entscheiden, wie das Problem zu beheben ist. Der verantwortliche Produktionsleiter sieht dann die Änderung in der Produktion, muss aber nicht selbst eingreifen. Über den digitalen Zwilling, den die Anlage kontinuierlich mit Daten füttert, lässt sich darüber hinaus die Qualität der Werkstücke und des Endprodukts laufend kontrollieren. Auch die Produktion einer Kleinserie mit individualisierten Einzelstücken lässt sich mit Hilfe dieses Konzepts schnell realisieren, und zwar so, dass die Gesamtproduktion nur minimal beeinträchtigt wird. Selbst die Losgröße-1-Produktion wird durch den Einsatz von Produktmodellen für die Generierung von Produktionsmodellen (etwa NC-Code) denkbar.

Vereinfachte Inbetriebnahme

Ein weiterer Vorteil des virtuellen Zwillings ist, dass er sich auch bereits bei der Konzeption und beim Bau der Produktionsanlage einsetzen lässt. Noch bevor das erste reale Werkstück bearbeitet wird, kann man so vorab den Produktionsablauf simulieren, Schwachstellen finden und optimieren. Auf diese Weise wird die Anlage bereits vor der Produktion virtuell in Betrieb genommen und getestet. Das beschleunigt die Planung und erleichtert die Inbetriebnahme einer neuen Produktionsanlage. Das Fraunhofer-Projekt liefert damit ein konkretes Beispiel, wie der Megatrend Industrie 4.0 funktionieren kann. „Unser Ziel ist, zentrale Technologien, Prozesse und Methoden von Industrie 4.0 nicht nur zu beschreiben, sondern wirklich erlebbar zu machen“, führt Rainer Stark aus, Leiter des Bereichs Virtuelle Produktentstehung am Fraunhofer IPK. Gemeinsam mit Industriepartnern wollen der Fraunhofer-Experte und sein Team bald erste Pilotprojekte zur Marktreife bringen. Um das ambitionierte Konzept realisieren zu können, mussten sie allerdings eine Reihe von technischen Herausforderungen bestehen. Viele der Techniken und Anwendungen für den digitalen Zwilling waren noch nicht verfügbar, die Forscher mussten sie daher eigens entwickeln. „Wir wollen gänzlich auf proprietäre Komponenten verzichten und bei allen Schnittstellen hundertprozentig kompatibel mit Industriestandards sein. Gleichzeitig darf das System nicht zu teuer werden, die Investition soll sich schließlich für das Unternehmen schnell amortisieren.“

Die Fraunhofer-Ingenieure nutzen eine Kombination aus physischen und virtuellen Sensoren. Dabei verarbeiten virtuelle Sensoren die Messdaten zu komplexen Reports über den Status der Anlage. Ein technisches Kernstück ist beispielsweise die Datenübertragung – sie ist innerhalb der Produktionsanlage und zum Kontrollzentrum hybrid ausgelegt. Es kommen also sowohl klassische Funkstandards wie WLAN und LTE als auch Industriestandards wie Ethercat zum Einsatz. Die Technik lässt sich beliebig skalieren. Sie ist in der Lage, einzelne Anlagen zu steuern, könnte aber auch eine ganze Fabrik überwachen. Die Grenzen liegen hier nur in der Rechnerleistung und den Netzwerkkapazitäten. Eine gewisse Einschränkung ergibt sich auch aus dem jeweils nötigen Aufwand bei der Modellierung und der Detailtreue beziehungsweise der Granularität des digitalen Zwillings. „Die smarte Fabrik ist aber dennoch kein modisches Schlagwort mehr, denn unser Konzept des digitalen Zwillings ist bereit für die Realisierung gemeinsam mit Industriepartnern“, so Rainer Stark abschließend.

Weitere Details zum Robust Design bei Fraunhofer: